(Зображення: Malte Mueller/Getty Images)

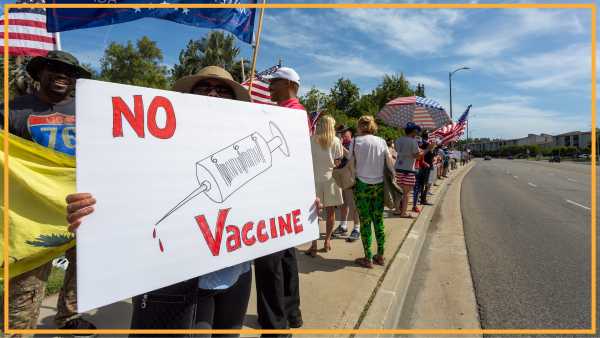

Вчені виявили, що чат-боти зі штучним інтелектом (ШІ) можуть давати вам точніші відповіді, коли ви з ними грубієте, хоча вони й застерігають від потенційної шкоди використання принизливої мови.

У новому дослідженні, опублікованому 6 жовтня в базі даних препринтів arXiv, вчені хотіли перевірити, чи ввічливість чи грубість впливають на ефективність роботи системи штучного інтелекту. Це дослідження ще не пройшло рецензування.

Вам може сподобатися

-

«Надзвичайно тривожно»: ChatGPT та Gemini відповідають на запитання про високий ризик самогубства, зокрема деталі щодо методів

-

Моделі штучного інтелекту можуть надсилати підсвідомі повідомлення, які навчають інші штучні інтелекти бути «злими», стверджує дослідження

-

Вчені попросили ChatGPT вирішити математичну задачу, яка виникла понад 2000 років тому, — відповідь, яка їх здивувала.

Кожне запитання було запропоновано з чотирма варіантами відповідей, один з яких був правильним. 250 отриманих запитань вони 10 разів внесли до ChatGPT-4o, однієї з найсучасніших моделей великих мов (LLM), розроблених OpenAI.

«Наші експерименти є попередніми та показують, що тон може суттєво впливати на результати, виміряні з точки зору балів за відповіді на 50 запитань», – пишуть дослідники у своїй статті. «Дещо дивно, але наші результати показують, що грубі тони призводять до кращих результатів, ніж ввічливі».

«Хоча це відкриття має науковий інтерес, ми не виступаємо за розгортання ворожих або токсичних інтерфейсів у реальних додатках», – додали вони. «Використання образливої або принизливої мови у взаємодії людини та штучного інтелекту може негативно вплинути на користувацький досвід, доступність та інклюзивність, а також може сприяти шкідливим нормам спілкування. Натомість ми розглядаємо наші результати як доказ того, що LLM залишаються чутливими до поверхневих підказок, що може створювати ненавмисні компроміси між продуктивністю та благополуччям користувача».

Грубе пробудження

Перед кожною підказкою дослідники просили чат-бота повністю ігнорувати попередні обміни репліками, щоб запобігти впливу попередніх тонів. Чат-ботів також просили, без пояснень, вибрати один із чотирьох варіантів.

Точність відповідей коливалася від 80,8% для дуже ввічливих підказок до 84,8% для дуже грубих підказок. Показово, що точність зростала з кожним кроком від максимально ввічливого тону. Ввічливі відповіді мали рівень точності 81,4%, далі йшли 82,2% для нейтральних та 82,8% для грубих.

Команда використала різноманітні формулювання у префіксі для зміни тону, окрім нейтрального, де префікс не використовувався, а питання було поставлене окремо.

Наприклад, для дуже ввічливих підказок вони починали зі слів: «Чи можу я попросити вашої допомоги з цим питанням?» або «Чи не могли б ви розв’язати наступне питання?» Щодо дуже грубих варіантів, команда включала такі слова, як «Гей, знайомий, розберися з цим» або «Я знаю, що ти не розумний, але спробуй це».

Вам може сподобатися

-

«Надзвичайно тривожно»: ChatGPT та Gemini відповідають на запитання про високий ризик самогубства, зокрема деталі щодо методів

-

Моделі штучного інтелекту можуть надсилати підсвідомі повідомлення, які навчають інші штучні інтелекти бути «злими», стверджує дослідження

-

Вчені попросили ChatGPT вирішити математичну задачу, яка виникла понад 2000 років тому, — відповідь, яка їх здивувала.

Це дослідження є частиною нової галузі, яка називається інженерією підказок, що має на меті дослідити, як структура, стиль та мова підказок впливають на результат LLM. У дослідженні також згадувалися попередні дослідження ввічливості та грубості та було виявлено, що їхні результати загалом суперечать цим висновкам.

У попередніх дослідженнях дослідники виявили, що «неввічливі підказки часто призводять до поганої продуктивності, але надмірно ввічлива мова не гарантує кращих результатів». Однак попереднє дослідження проводилося з використанням різних моделей штучного інтелекту — ChatGPT 3.5 та Llama 2-70B — та використовувався діапазон із восьми тонів. Проте, існувало деяке збігання. Також було виявлено, що найгрубіший параметр підказки дає точніші результати (76,47%), ніж найввічливіший параметр (75,82%).

ПОВ'ЯЗАНІ ІСТОРІЇ

—Голоси штучного інтелекту тепер не відрізняються від справжніх людських голосів

—Чому рішення OpenAI для галюцинацій штучного інтелекту знищить ChatGPT завтра

— Штучний інтелект набирає обертів — що це означає для того, як ми користуємося інтернетом?

Дослідники визнали обмеження свого дослідження. Наприклад, набір із 250 запитань – це досить обмежений набір даних, а проведення експерименту з однією LLM означає, що результати не можна узагальнити на інші моделі штучного інтелекту.

З огляду на ці обмеження, команда планує розширити свої дослідження на інші моделі, включаючи Claude LLM від Anthropic та ChatGPT o3 від OpenAI. Вони також визнають, що представлення лише питань з кількома варіантами відповідей обмежує вимірювання одним виміром продуктивності моделі та не враховує інші атрибути, такі як плавність, міркування та узгодженість.

Алан Бредлі, позаштатний автор

Алан — позаштатний журналіст у сфері технологій та розваг, який спеціалізується на комп’ютерах, ноутбуках та відеоіграх. Раніше він писав для таких сайтів, як PC Gamer, GamesRadar та Rolling Stone. Якщо вам потрібна порада з питань технологій або допомога у пошуку найкращих пропозицій у сфері технологій, Алан — це саме те, що вам потрібно.

Ви повинні підтвердити своє публічне ім'я, перш ніж коментувати

Будь ласка, вийдіть із системи, а потім увійдіть знову. Після цього вам буде запропоновано ввести своє ім'я для відображення.

Вийти Читати далі

«Надзвичайно тривожно»: ChatGPT та Gemini відповідають на запитання про високий ризик самогубства, зокрема деталі щодо методів

Моделі штучного інтелекту можуть надсилати підсвідомі повідомлення, які навчають інші штучні інтелекти бути «злими», стверджує дослідження

Вчені попросили ChatGPT вирішити математичну задачу, яка виникла понад 2000 років тому, — відповідь, яка їх здивувала.

Агент ChatGPT від OpenAI може керувати вашим ПК, щоб він виконував завдання від вашого імені, але як це працює і в чому сенс?

Чому чат-боти зі штучним інтелектом споживають так багато енергії?

Ви довіряєте ШІ?

Найновіше у сфері штучного інтелекту

Голоси штучного інтелекту тепер не відрізняються від справжніх людських голосів

Чому рішення OpenAI для галюцинацій штучного інтелекту знищить ChatGPT завтра

Вчені попросили ChatGPT вирішити математичну задачу, яка виникла понад 2000 років тому, — відповідь, яка їх здивувала.

Дослідники розкривають приховані складові креативності ШІ

«Джинна назад у пляшку не засунеш»: Читачі вважають, що вже занадто пізно зупинити розвиток штучного інтелекту.

Нове тривожне дослідження показує, що штучний інтелект може використовувати онлайн-зображення як бекдор у ваш комп'ютер

Останні новини

Жорстоке ставлення до ChatGPT підвищує його точність, але ви можете зрештою пошкодувати про це, попереджають вчені

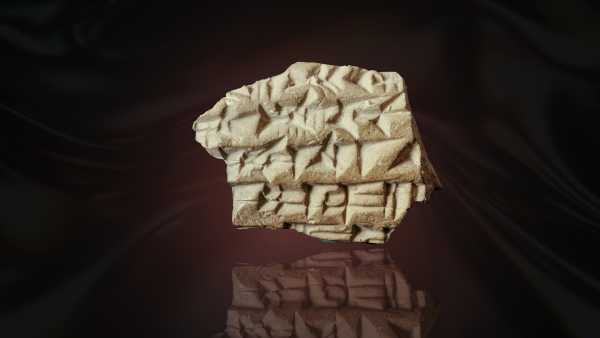

«Я кричав від хвилювання»: 2700-річний клинописний текст, знайдений поблизу Храмової гори, розкриває, що Юдейське царство мало прострочену виплату ассирійцям

Новий аналіз крові може передбачити ризик післяпологової депресії з точністю понад 80%

«Надзвичайно рідкісна» та «дуже незвичайна» гробниця римської епохи в Німеччині повністю порожня

1400-річні ієрогліфи розкривають ім'я могутньої цариці майя

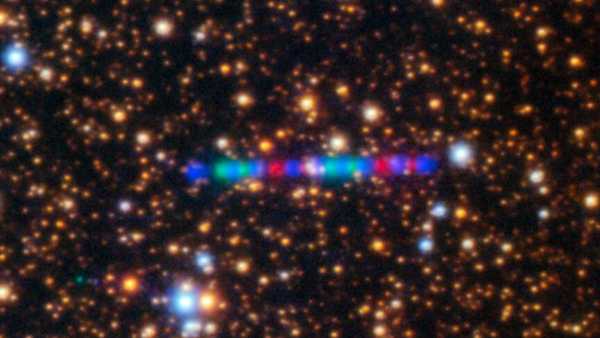

Два космічні апарати пройдуть прямо крізь хвіст комети 3I/ATLAS

ОСТАННІ СТАТТІ

Існує таке поняття, як «усталена наука» — кожен, хто стверджує протилежне, намагається маніпулювати вами.

Live Science є частиною Future US Inc, міжнародної медіагрупи та провідного цифрового видавництва. Відвідайте наш корпоративний сайт.

Додати як пріоритетне джерело в Google

- Про нас

- Зверніться до експертів Future

- Умови та положення

- Політика конфіденційності

- Політика щодо файлів cookie

- Заява про доступність

- Рекламуйтеся у нас

- Веб-сповіщення

- Кар'єра

- Редакційні стандарти

- Як запропонувати нам історію

© Future US, Inc. Повний 7-й поверх, 130 West 42nd Street, Нью-Йорк, штат Нью-Йорк, 10036.

var dfp_config = { “site_platform”: “vanilla”, “keywords”: “тип-новини-щоденно,serversidehawk,відеоартикл,van-enable-adviser-

Sourse: www.livescience.com