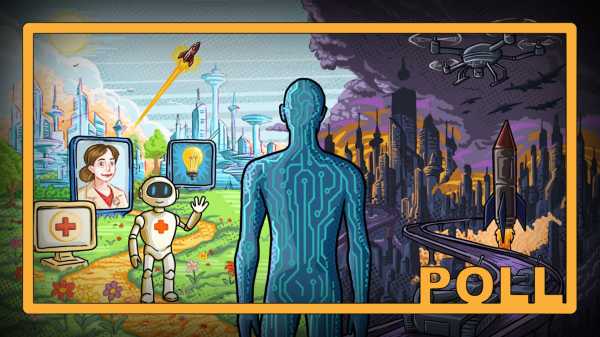

Штучний інтелект швидко наближається до технологічної сингулярності. Як ми можемо забезпечити хороше майбутнє, яке він відкриває? (Зображення: Рорі Макнікол для Live Science)

Навколо штучного інтелекту (ШІ) точаться численні дискусії, враховуючи вибухове зростання його можливостей, від побоювань, чи він позбавить нас робочих місць, до сумнівів у тому, чи можемо ми взагалі йому довіряти.

Але ШІ, який використовується сьогодні, не є ШІ майбутнього. Вчені дедалі більше переконані, що ми їдемо експресом до створення штучного загального інтелекту (ЗШІ) — передового типу ШІ, який може міркувати як люди, працювати краще за нас у різних сферах і навіть покращувати власний код і ставати потужнішим.

Експерти називають цей момент сингулярністю. Деякі вчені кажуть, що це може статися вже наступного року, але більшість погоджується, що існує велика ймовірність того, що ми побудуємо ЗШІ до 2040 року.

Вам може сподобатися

-

Чи позбавить нас аутсорсингу всього ШІ здатності думати самостійно?

-

Штучний інтелект незабаром зможе мислити так, як ми навіть не розуміємо, — уникаючи наших зусиль щодо його узгодження — попереджають провідні вчені у сфері штучного інтелекту

-

Агент ChatGPT від OpenAI може керувати вашим ПК, щоб він виконував завдання від вашого імені, але як це працює і в чому сенс?

Але що тоді? Народження ШІ, розумнішого за людей, може принести безліч переваг, зокрема швидке проведення нових наукових досліджень та здійснення нових відкриттів. Але ШІ, який може створювати дедалі потужніші версії себе, також може бути не такою вже й гарною новиною, якщо його інтереси не збігаються з інтересами людства. Саме тут вступає в гру штучний суперінтелект (ШСІ) — і потенційні ризики, пов'язані з прагненням до чогось набагато потужнішого за нас.

Розробка штучного інтелекту, як повідомили експерти виданню Live Science, вступає в «безпрецедентний режим». Тож чи варто нам зупинити її, перш ніж вона стане достатньо потужною, щоб потенційно знищити нас одним клацанням пальців? Повідомте нам про це в опитуванні нижче та обов’язково напишіть у коментарях, чому ви проголосували саме так.

Пов'язані історії

— Штучний інтелект вступає в «безпрецедентний режим». Чи повинні ми зупинити його — і чи можемо ми це зробити — перш ніж він нас знищить?

— Вчені кажуть, що ШІ може вийти з ладу 32 різними способами — від галюцинаційних відповідей до повної невідповідності з людством.

— Дослідження попереджає, що якщо погрожувати чат-боту зі штучним інтелектом, він брехатиме, обманюватиме та «дозволить вам померти», намагаючись вас зупинити.

Кеумарс Афіфі-Сабет, редактор каналу, технології

Кьомарс — редактор відділу технологій у Live Science. Він писав для різних видань, зокрема ITPro, The Week Digital, ComputerActive, The Independent, The Observer, Metro та TechRadar Pro. Він пропрацював журналістом у сфері технологій понад п'ять років, раніше обіймав посаду редактора спеціалізованих матеріалів в ITPro. Він має кваліфікацію журналіста NCTJ та ступінь з біомедичних наук Лондонського університету Королеви Марії. Він також зареєстрований як дипломований менеджер-основоположник в Chartered Management Institute (CMI), отримавши кваліфікацію керівника команди 3-го рівня з відзнакою у 2023 році.

Ви повинні підтвердити своє публічне ім'я, перш ніж коментувати

Будь ласка, вийдіть із системи, а потім увійдіть знову. Після цього вам буде запропоновано ввести своє ім'я для відображення.

Вийти Читати далі

Чи позбавить нас аутсорсингу всього ШІ здатності думати самостійно?

Штучний інтелект незабаром зможе мислити так, як ми навіть не розуміємо, — уникаючи наших зусиль щодо його узгодження — попереджають провідні вчені у сфері штучного інтелекту

Агент ChatGPT від OpenAI може керувати вашим ПК, щоб він виконував завдання від вашого імені, але як це працює і в чому сенс?

Мета-ШІ робить перший крок до суперінтелекту — і Цукерберг більше не випускатиме найпотужніші системи для публіки

Штучний інтелект перехитрив 30 найкращих математиків світу на секретній зустрічі в Каліфорнії

Штучний інтелект частіше галюцинує, чим більш розвиненим стає. Чи є спосіб це зупинити? Найновіше у світі штучного інтелекту

«Надзвичайно тривожно»: ChatGPT та Gemini відповідають на запитання про високий ризик самогубства, зокрема деталі щодо методів

Ви довіряєте ШІ?

Штучний інтелект не може розв'язати ці головоломки, які займають у людей лише секунди

Вчені кажуть, що ШІ може вийти з ладу 32 різними способами — від галюцинаційних відповідей до повної невідповідності з людством

Вчені щойно розробили новий штучний інтелект, змодельований за зразком людського мозку, — він перевершує LLM, такі як ChatGPT, у завданнях мислення.

IBM та NASA створюють перший у своєму роді штучний інтелект, який може точно передбачати сильні спалахи на Сонці. Останні новини.

Ген, який людські предки втратили мільйони років тому, може допомогти в лікуванні подагри

Китайський підводний апарат досліджує раніше невідомі гігантські кратери на дні Тихого океану — і вони кишать життям

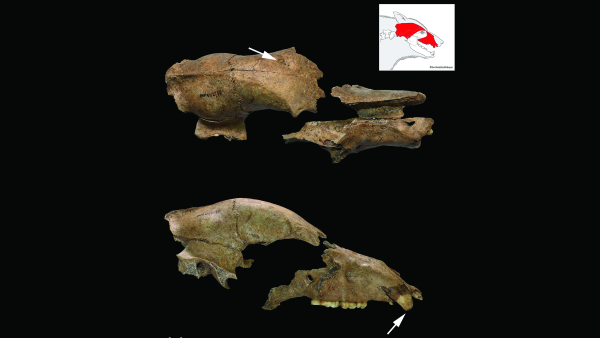

Череп ведмедя, якого тримали в полоні для битв з римськими гладіаторами, знайшли поблизу стародавнього амфітеатру в Сербії

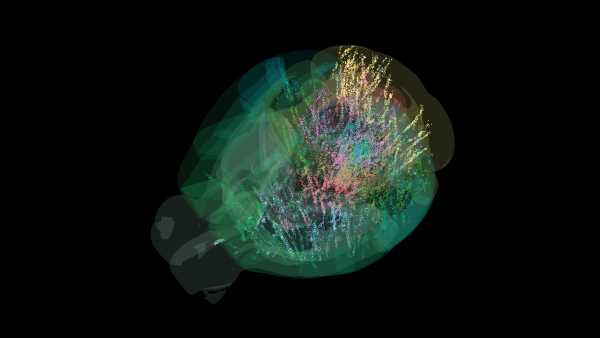

Мапа з 600 000 клітин мозку переписує підручник про те, як мозок приймає рішення

Як ви вважаєте, чи варто нам зупинити прогрес штучного інтелекту, перш ніж він стане загрозою для нашого виду?

Телескоп Джеймса Вебба виявив дивний диск навколо зірки, який може зруйнувати теорії формування планет.

Ген, який людські предки втратили мільйони років тому, може допомогти в лікуванні подагри

Live Science є частиною Future US Inc, міжнародної медіагрупи та провідного цифрового видавництва. Відвідайте наш корпоративний сайт.

- Про нас

- Зверніться до експертів Future

- Умови та положення

- Політика конфіденційності

- Політика щодо файлів cookie

- Заява про доступність

- Рекламуйтеся у нас

- Веб-сповіщення

- Кар'єра

- Редакційні стандарти

- Як запропонувати нам історію

© Future US, Inc. Повний 7-й поверх, 130 West 42nd Street, Нью-Йорк, штат Нью-Йорк, 10036.

var dfp_config = { “site_platform”: “vanilla”, “keywords”: “no-in-article-video,van-disable-in-body-ads,type-poll,van-disable-newsletter,exclude-from-syndication,serversidehawk,van-enable-adviser-

Sourse: www.livescience.com